半自動ビデオアノテーションとそれに基づく意味的ビデオ検索

1 はじめに

近年Webページをはじめ、さまざまな情報検索が頻繁に行われている。 しかしながら、ビデオコンテンツに対するWeb検索はいまだ実用化 されているとは言い難い。 ビデオコンテンツに対する検索にはさまざまな手法 が存在するが、ビデオコンテンツを全自動で 解析した結果に基づいて検索する場合、精度の観点からきわめて不 十分である。検索の精度を十分に実用的なレベルに引き上げるため にはビデオコンテンツに検索や変換・編集等に有効な意味内容記述を なんらかの方法により付加する必要がある。そこで、コンピュータ によるビデオコンテンツの自動解析を行い、人間がその解析結果を 効率よく修正・補完できるツールを作成した。さらにそのツールを 使用して得られたアノテーションデータに基づいて、高度な意味的 ビデオ検索をWebブラウザを用いて自然言語で行うシステムを試作した。

2 ビデオアノテーションエディタ

本研究で作成したアノテーションツールをビデオアノテーションエディタ (以下VAEと略す)と呼ぶ。 長尾ら が作成したバージョンのVAEをベースに新たに作り直した。 VAEは動画像に対してカット検出、オブジェクトトラッキング、シーンおよび オブジェクトへのアノテーション、音声認識を用いたトランスクリプトの作成、 XMLデータ出力等が行えるツールである。

主要な機能として以下のものを備えている。

-

カット検出

カット検出は、RGB空間を4096分割したカラーヒストグラムを用いて 各画素の絶対値差分の合計がある閾値以上になれば新たなカットであると 認識している。

-

オブジェクトトラッキング

オブジェクトトラッキングダイアログ(図) を利用しておこなう。 アルゴリズムは、矩形範囲をキー画像として、テンプレートマッチングを 行っている。 トラッキングしたオブジェクトの始めの画像と終わりの画像・ さらにその前後 0.1秒の画像を表示し、トラッキングが成功しているかどうか、 一目でわかるように工夫してある。また、手動での修正も可能である。

また、MPEGコンテンツはランダムアクセスが遅いために、 3秒ごとに動画をメモリ上に展開し処理を行った。

-

複数選択式アノテーション

あらかじめ、アノテーションに対する3つの定義ファイル(オブジェクト の属性を定義するobjectDefinitions.xml, オブジェクトの動作を 定義するmotionDefinitions.xml, シーンの状況を定義する sceneDefinitions.xml)を用意し、それぞれプルダウンメニューを 選択することにより意味内容を記述する。複数の項目を同時に選択 することにより、より複雑な状況も記述可能である。また、ユーザが独自に これらのXML定義ファイルを拡張することも可能である。

XML定義ファイルには、新たな項目を作るだけでなくその項目の説明をする 必要がある。RDFスキーマなどグラフ構造を用いた定義の表現方 法が存在するが 今回はより簡略かつ検索に使いやすいように、新しい項目に関する さまざまな同義語(日本語、英語を含む)を列挙することにした。 この方式ならば、手軽に項目追加が可能であるし、検索時に完全一致、 あるいは、部分一致が容易であると考えられるからである。

-

音声認識

IBMの音声認識ソフトViaVoiceを使って音声認識を行う。 その音声が発話された 時間区間の自動抽出も行う。認識結果の修正機能も備えている。

-

階層構造の表現とシーンの重要度の推定

文章などと同様に映像にもカットを単位とした階層構造が存在し、 半自動的にアノテーションすることが可能である。 類似カットのつながりを類似度に応じて自動的に グルーピングすることができる。 類似度は、ヒストグラム、シーンの長さ、音声などを考慮して 実現可能である。 また重要度をシーンの長さとアノテーションのデータ量に応じて 上げる試みもしている。

-

XML出力

記述内容の拡張性とWebベース検索の容易性を考慮し XMLファイルによる出力を採用した。

3 自然言語による意味的ビデオ検索

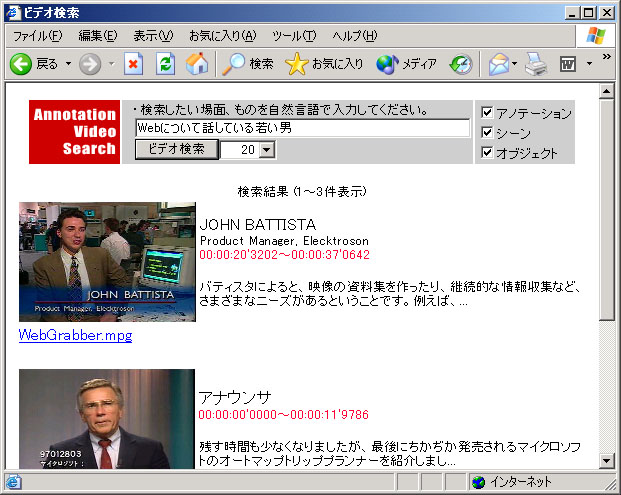

VAEによって作られたXMLアノテーションデータを、 Webブラウザを用いて 検索するシステム(図)をJava Servletと XMLデータベースを用いて 試作した。検索は、自然言語入力によって行っている。 アルゴリズムとしては以下のようになる。

-

検索キーワードから茶筅を用いて、形容詞・動詞・名詞を取り出す。

-

形容詞から色にあたる単語(たとえば、赤い・黒い・青い・暗い・ 明るい等) がある場合はシーンもしくはオブジェクトのヒストグラムも利用して 検索結果を絞り こむ。このとき、色にあたる形容詞にかかる名詞が「場面」「光景」 「風景」 「シーン」「画面」等の場合はシーンについて語っている可能性が高 く、 それ以外の場合はオブジェクトに関する場合が高いのでそれに応じて 点数をつける。 また、これ以外の名詞・形容詞・動詞は、アノテーションデータに記述 されたテキスト情報もしくは、選択式アノテーションによりつけられた 記述との部分もしくは完全一致により点数をつける。

-

オブジェクトもしくはシーンを点数順に並び替え、順位づけされた 検索結果をユーザーに提示する。

図1: ビデオの検索画面例

4 終わりに

今回は、ビデオコンテンツに対するアノテーションツールと、自然言語に よる検索ツールを試作した。従来難しいと思われていた自然言語による ビデオコンテンツ検索が、アノテーションを併用することにより比較的容易に なることを示した。 これにより、ユーザはGoogleと同様の感覚で 動画像データを 意味的に検索できるようになる。