Web社会活動に基づく映像シーンアノテーション

概要

我々は,映像シーンについて議論するために掲示板システムやブログツールなどを利用するコミュニティの活動から映像コンテンツの意味を獲得する仕組みについて述べる.これらのコミュニティ活動にはビデオ応用に役立つ情報が含まれているので,それらをアノテーションとして獲得する.我々はSynvieと呼ばれるWebベースのビデオ共有とアノテーションのためのシステムを開発した.また,映像シーンに関連付けられたユーザコメントやシーンを引用したブログエントリーを獲得するために,システムの評価を目的とした公開実験を実施した.我々は,また,本実験で獲得したアノテーションに基づく,タグを用いたビデオシーン検索システムを開発した.

1 はじめに

近年,商用目的だけではなく一般ユーザも映像や音楽コンテンツを共有するにつれて,非常に多くのマルチメディアコンテンツがWeb上に存在している.同時に,WeblogやSNSやWikiなどといったWebコミュニケーションツールの登場の結果,Webコミュニティの発言力も強くなってきている.motionbox.comやjumpcut.com,kaltura.comなどといったビデオ編集機能をもつビデオ共有サービスは既に存在している.しかしながら,これらのシステムでは,ユーザがコミュニケーションのために映像を編集したり共有したりすることができるが,映像の中身を理解するための機能はない.それゆえユーザが容易に映像コンテンツを投稿し,管理し,検索することができるツールや基盤的システムの必要性がある.

ビデオの要約やシーン検索などの応用を実現するためには映像の内容に関するメタ情報を獲得する必要がある.ここではそれらの情報をアノテーションと呼び, それはコンテンツに関連するキーワードから抽出可能である.以前の研究において,画像認識や音声認識技術を用いてメタデータを抽出する自動抽出手法や,MPEG-7 を記述するように,専任のアノテータが専用のツールを用いて高品質なアノテーションを付与する半自動手法があった. 素人が作成したビデオにはノイズや不明瞭な声や手ぶれやピンボケなどがあるので質は高くなく,それゆえ自動認識の精度は高くない.自動認識技術はそれゆえ必ずしも素人映像には有効ではない.素人が作った映像作品のほかの問題として,すべてのそれらのコンテンツに対して詳細なアノテーションを関連付けるには費用対効果が見合わないというものがある.

そこで我々はこれらの問題に対する新しい手法を提案する.それは社会的活動,つまり,映像コンテンツの内容に対するユーザコメントやブログ執筆に基づく手法である.我々は映像の中身にコメントを関連付けるオンライン電子掲示板型のコミュニケーションや映像シーンを引用したブログ執筆支援のための仕組みを開発した.また,自動的にコンテンツの内容と関連した情報をアノテーションとして獲得した.我々は,提案したシステムのコストは低いことを示し,システムは自動認識システムを使ったものよりもロバストである.

本論文は8章から成る.2章では関連研究について記述する.3章において我々のシステムの概要について記述し,4章においてビデオシーンに対するコメントや引用に関する手法を記述する.5章においてアノテーションに含まれるテキストメッセージからタグの自動抽出について記述し,それらのタグの半自動スクリーニングについて述べる.7章ではこれらのタグをどのように応用に役立てるかを書き,8章でこの論文をまとめ,今後の課題を書く.

2 関連研究

既にWebには映像共有や映像編集サービスが多く存在する.

いくつかのビデオ共有サービス,たとえば,YouTube ( http://www.youtube.com/ )は,既に映像をブログに埋め込みコメントを書くための機能を提供している.コメントを書くといった掲示板型のコミュニケーションやブログエントリーでのそれらの埋め込みはすでに日常的に行われている.また,ユーザが容易に映像を共有・編集できるサービスが既に存在する.たとえば,motionbox.com, jumpcut.com, and kaltura.comなどである.これらのシステムの目的は映像を共有することによってコミュニケーションを支援することであるため,それらは映像の内容を理解することを目的としたビデオアノテーションの機能は備えていない.それらのコミュニケーションは,映像コンテンツと関連付けられたアノテーションとして見なせるかもしれないが,しかしながら,これらのアノテーションは映像全体を対象としたものであるため,映像の一部分のみを抽出することができない.それゆえ映像の内容検索には利用できない.

ビデオや映像の内容を理解するために,WebEVAやGoogle Image LabelerなどといったWebアノテーションシステムが存在している.IBM Efficient Video Annotation(WebEVA)はWebベースのシステムであり,TRECVIDのために非常に多くの映像と画像のコレクションに対して協調的に概念を関連付けることができる.多くのユーザーがコンセプトと画像の関係を,positive, negative, igonore, skipiと評価することができる.多くのユーザが同時にこれらを評価すると,それらには矛盾した評価があるかもしれない.

ESP GameやGoogle Image Labeler ( http://images.google.com/imagelabeler/ ) は,ユーザーがエンターテイメントの形式で,画像にタグを付与することを可能にする手法である.ユーザがランダム画像に対してラベルを付与することができ,画像検索結果の品質を向上させることができるオンラインコンテストである.これは最小の努力で,かつ,エンターテイメントを提供する非常によい手法だ.この手法によって取得されたタグは画像の内容に基づく検索の技術的向上に役立つ.

それゆえ,これらのアノテーションシステムの目的は,アノテーションと応用システムを作ることであるため,コミュニケーションを支援するわけではない.そこで,我々は映像編集システムとWebアノテーションシステムの良いところを組み合わせたビデオにおける内容アノテーションの新しい手法を提案する.

一方で,Web記事を配信し効率よくそれを蓄積する機能を持つWebloが非常に多く存在している.Weblogは非常に多くの標準,たとえばパーマリンクや,トラックバック,Web Feedなどといったものに準拠しているため,Weblogサイトは容易に人間だけでなく機械にも扱うことができる.パーマリンクは特定のコンテンツを指し示すURLのことであり,半永久的に変更されず維持される.Web FeedはRSSリーダやブログ検索のためのWebエントリーをXML形式で表現したものである.さらに,トラックバックは逆リンクを自動的に生成する引用のメカニズムとして存在している.これらの機能を組み合わせることによって,複数のブログサイトやツールによって協調的に作用する.

3 ソーシャルコンテンツ基盤

他のWeb映像共有サービスでは,一般ユーザがより細かい要素,つまり,シーンやフレームに対してアノテーションや引用などといったようなWeb社会活動はサポートしない.そこで,ユーザにとって使いやすい新しいビデオアノテーションシステムが必要である.それゆえ,我々は,HTMLコンテンツの管理,配信,機械的処理において一定の成果があるWeblog基盤の仕組みを参考にしてそれらをデザインする.

3.1 Weblogから学ぶ

ブログはパーマリンクやトラックバックなどといった機能を持っているため,他のウェブサイトと密に連携し,コメント付与に基づく記事の議論をすることができる.Parkerはこれらの技術をビデオに適用することによって,ビデオブログ検索やビデオブログフィーディンぐなどが可能になると述べている.我々は,ビデオシーン検索などのような先進的なビデオ応用へ,ビデオシーンに対するパーマリンクの機能やコメント機能が有効であると信じている.

3.2 iVAS

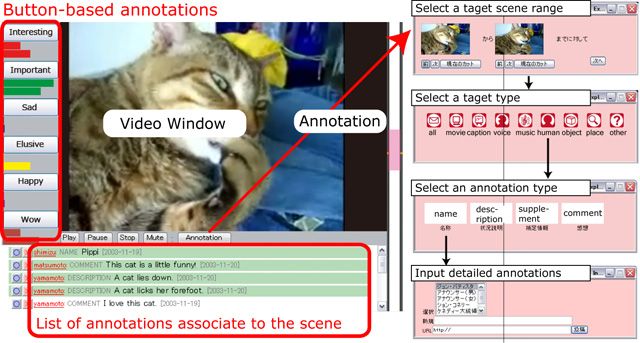

我々は以前の研究においてiVASと呼ばれる映像アノテーションシステムを開発した.(図)iVASではユーザが詳細なコメントを映像の内部に閲覧しながら付与することが可能なウェブアノテーションツールであったが,それは主にユーザのコメントや印象を共有するコミュニケーションツールとして利用された.それらのコメントは短く不明瞭であったが,シーンに対応した有用なキーワードを含んでいた.iVASの仕組みを拡張することによってより有用なコメントを獲得できるのではと考えた.

図1: オンラインビデオアノテーションシステムiVASのインタフェース

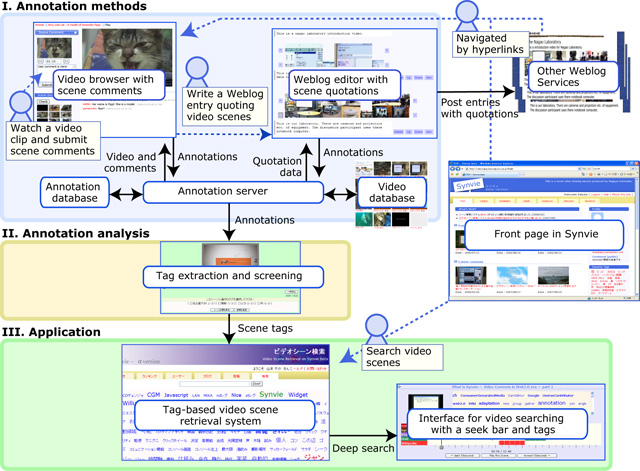

3.3 システム構成

我々はSynvieと呼ばれるシーンコメントとシーン引用を提供するビデオ共有サービスを開発した.我々の目的はWebユーザの社会的活動からアノテーションデータの獲得を目指し,アノテーションに基づく応用システムの開発することが目的である.この概要は図に示す.アノテーション手法では,ユーザが任意の映像を閲覧し,映像シーンに対するコメントの投稿と閲覧,一般的なブラウザを用いて映像シーンを引用することができる.(詳細は4章). これらのユーザコメントとコメントとビデオシーンの関係はアノテーションデータベースに蓄積される.アノテーション解析のブロックでは,蓄積されたアノテーションからタグを生成する.(詳細は5章). 応用ブロックでは,タグに基づくビデオ検索システムを提供する.(詳細は7章).

図2: オンラインビデオアノテーションと引用システムSynvieの概要

3.4 ビデオショットとシーン

ビデオはショットの集合で表現される.ショットはカメラから撮影された画像フレームの列として定義される.二つのショットの区切れはカットと呼ばれている.ブログにおけるビデオショットのいくつかはとても長いため(つまり,人が話している),より意味的に扱うために我々のシステムでは2秒間隔のサブショットに分割している.ここで,我々のシステムではビデオから最良の代表キーフレームを選択するために,我々のシステムは一定間隔の時間的サンプリングを組み合わせている.

4 アノテーション手法

明示的なアノテーション(たとえばMPEG-7のような)とは意味,属性,ビデオの構造をユーザが記述したものである.タグと内容記述はまた明示的なアノテーションである.その一方で,暗黙的なアノテーションとは,Web社会的活動,たとえば,コメントの投稿やブログを書くなどといったユーザ行動から抽出したものである.暗黙的なアノテーションにはいくつかの解析誤りが存在するが,アノテーションを作成する面倒からユーザは解放される.コミュニケーションのためのツールやブログエントリーを書くためのツールを提供することによって,Synvieは暗黙的なアノテーションの作成を支援する.

ここで,YouTubeのコメント領域のようなユーザコメントを「コンテンツコメント」,特定の映像シーンに対するユーザコメントを「シーンコメント」として定義しよう.そして,ブログエントリーにおける映像シーンの引用する仕組みをシーン引用と定義しよう.

4.1 シーンコメント

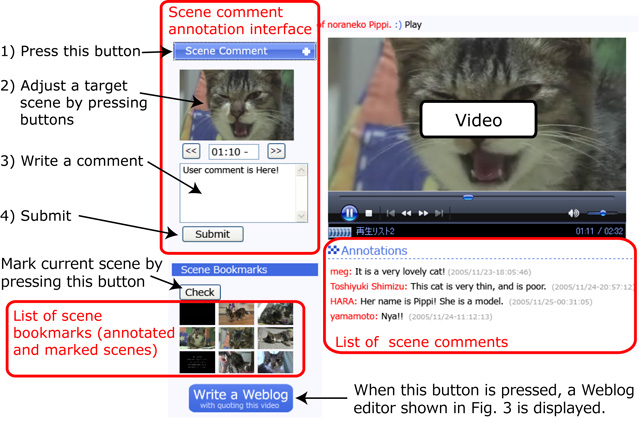

シーンコメント型アノテーションは一般的なユーザに映像シーンとテキストメッセージを関連付けることを可能にする仕組みである.映像シーンに容易にコメントを投稿するインタフェースが必要であるため,我々はiVASのアノテーションインタフェースを簡略化した.このインタフェースはユーザコミュニケーションに特化している.

映像を見ている間にシーンにコメントを付与するために,ユーザは「シーンコメント」と書かれたボタンを押すと,ビデオは停止し映像シーンに関連したサムネイル画像が表示される.(図)もしその画像が適切でなければ,ユーザは「<<」「>>」ボタンを押すことによってシーンの開始時間を調整可能である.サムネイル画像が適切に変化し,その開始時間にユーザは満足したら調整ボタンの下のテキストエリアにコメントを記入し,投稿ボタンを押す.もしユーザが後でコメントを投稿したいが今は投稿したくない場合には,「チェック」ボタンを押すことによってシーンをブックマークできる.以前に投稿したシーンやブックマークしたシーンの一覧が左下に表示される.(図)

それぞれのシーンコメントは,対応するシーンが表示されると表示され,同じシーンに対応するいくつかのメッセージが同時に表示される.このインタフェースは非同期にほかのユーザと映像シーンに対するメッセージの交換を可能にする.

このコミュニケーションスタイルは電子掲示板のユーザが感動を共有し情報を交換する行為と似ている.

図3: シーンコメント型アノテーションのインタフェース

4.2 シーン引用

ビデオシーン引用とは,ユーザがブログエントリーに映像シーンを引用するための機能である.ブログエントリーにおいて映像シーンをユーザが引用することを支援することによって,我々はユーザの詳細な編集履歴を獲得し,ビデオコンテンツのシーン構造とブログエントリーの文章構造を関連付けたアノテーションを獲得することができる.

4.2.1 ビデオブログとは何?

映像シーンを引用したブログエントリーをビデオブログエントリーと呼ぶ.

既に映像について議論する多くのビデオブログエントリーが存在することを期待し,二つの種類について考慮する.ひとつは,映像コンテンツを投稿したユーザがコンテンツを紹介する記事を書くものである.ユーザはそれを引用した特定の部分に容易に指し示すことができる.このタイプのエントリーは映像コンテンツの宣伝に有効であろう.もう一つの種類のエントリーは,ビデオを閲覧しリンク付けしたユーザがほかのユーザに向けて映像コンテンツを紹介する記事を編集するタイプである.映像コンテンツがより人気が出るにつれより多くの記事が投稿されることを期待する.

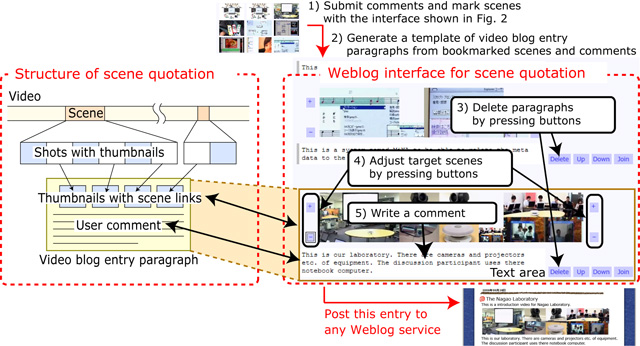

ビデオブログエントリーは映像シーンを引用した複数の段落から構成され,それぞれの段落は映像シーンを引用したサムネイル画像と,ユーザコメントと,映像シーンに対するリンクを含んでいる.(図)我々はコメントをシーンに対するアノテーションとして扱い,この種類のアノテーションをシーン引用と呼ぶ.

4.2.2 シーンコメントとの連携

ユーザは引用したいシーンを引用する必要があり,この選択のために,シーンアノテーションと同じメカニズムを利用する.ユーザにとって面白いシーンにはユーザはシーンコメントを投稿すると仮定する.それゆえ,ブログエントリーにおいてシーンを引用する候補となり,ユーザはこれらの候補のシーンを引用することによってビデオブログエントリーを編集可能である.

4.2.3 ビデオブログツールのインタフェース

ユーザは通常のブログエントリーを編集する時と同様に,一般的なWebブラウザでビデオブログが編集できれば一番良いと考えた.ここで,連続するシーンを引用したビデオブログエントリーを編集するのに適したビデオシーン引用のためのインタフェースを図に示す.このインタフェースはユーザがシーンを選択し,開始と終了の時間を調整し,シーンコメントよりも長いメッセージを記述することができる仕組みである.具体的なステップをいかに示す.

-

STEP 2. 図のブログを書くボタンを押し, 図4に現れるブログ編集のための別のインタフェースに移行する.このインタフェースは図に示すシーンブックマークから自動的に抽出されたビデオブログテンプレートを表示する.

-

STEP 3. STEP1でマークされたすべてのサムネイル画像を閲覧し,不要な段落を図4の削除ボタンを押すことによって取り除く.

-

STEP 4. 図4の+やーボタンを押すことによってシーンの間隔を調整する.

-

STEP 5. シーンのサムネイル画像の下のテキストエリアにメッセージを書き,既存のWeblogサービスにHTMLの形式で自動生成されたものを投稿する.

このインタフェースは,時間軸上で映像ショットの伸縮することによって引用したい連続するシーンの開始時刻と終了時刻を調整することができるので,我々はシーンコメントよりもより正確なシーンを選択することが可能である.このインタフェースは映像のストーリの記述に重きを置いた記事の編集に適している.

ブログサイトに投稿されるとアノテーションデータベースにブログエントリーは蓄積される.

図4: シーン引用の構造とブログインタフェース

4.2.4 暗黙的アノテーションとしてのシーン引用

我々はシーン引用もアノテーションとして扱う.シーン引用には二つの異なるタイプのアノテーションの特性がある.

ひとつはより正確で情報量のあるシーンコメントとしての側面である.ビデオブログエントリーの段落は引用したシーンのアノテーションとして考えられ,それらの文章は,映像を閲覧しながら作成したシーンコメントよりも丁寧な言葉づかいでミススペルの少ないものであろう.なぜならば,ビデオブログはより注意深くかけるからだ.

他方は,映像シーン間の意味的な関係だ.一つの映像コンテンツの連続するシーンを同時に引用することは,それらのショットの間で意味的なつながりがあるはずだ.異なるビデオのシーンを同時に引用することは,引用したシーンとビデオの間に意味的な関係があるかもしれない.たとえば,ユーザがビデオブログにおいて異なるビデオのシーンを同時に引用した場合,システムはこれらのシーンやコンテンツに意味的な関連性を見つけるかもしれない.我々は将来的にこれらの関係性に基づく意味的な類似性を計算できるかもしれない.

5 アノテーションの解析

本システムでは,シーンコメントやシーン引用を,なるべく情報劣化がない形式で蓄積する.そのため,本研究で意味するところのアノテーションはユーザコメントの列挙にすぎず,それ自身が機械によって理解可能な情報とは限らない.つまり,本研究によって取得されたアノテーションを用いたアプリケーションを構築するためには,アノテーションを解析し,機械が理解可能な情報に変換する必要がある.

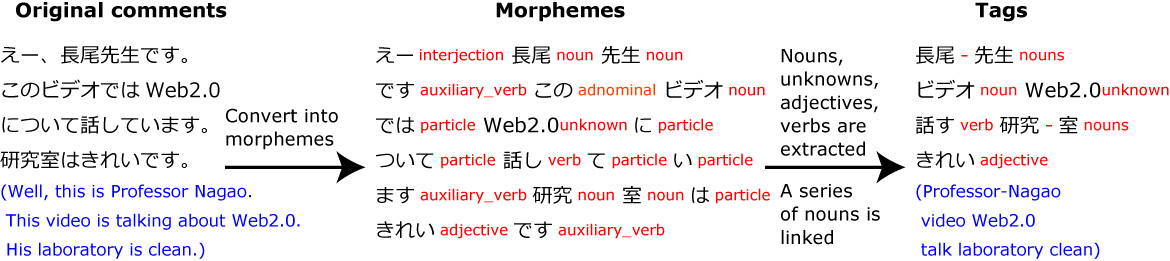

5.1 タグ抽出

シーンの意味をあらわすキーワードをシーンコメントから抽出する.そしてそのコンテンツと関連付けられたキーワードをタグと呼ぶ.特に,シーンと関連付けられたキーワードをシーンタグと呼ぶ.これらは以下の手順において抽出される(図).それぞれのコメントや最初に自動的に解析され,形態素に分割される.そして,形式名詞以外の名詞,形式動詞以外の動詞,形容詞,未知語が獲得される.未知語は固有名詞として扱う.形態素解析には日本語形態素解析システムであるChaSen を利用する.それぞれの形態素の基本形がタグになる.

複合語をもつタグを生成することはこの方式ではできないので,連続する名詞はタグとして拡張した.我々のシステムではおもに日本語で記述されていることを仮定しているため,もしも連続するアルファベット,たとえば,Web2.0のようなものが日本語文章中に現れたら,それらもタグとして扱う.

図5: コメントからのタグ抽出

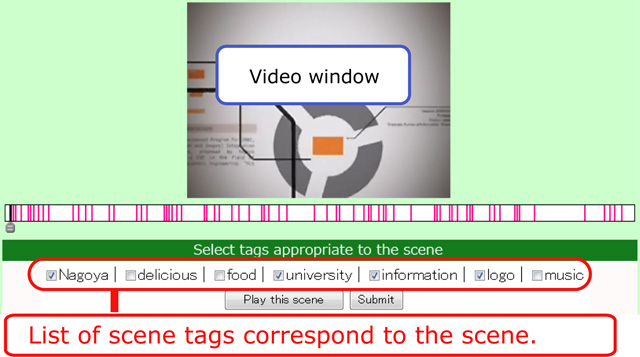

5.2 タグ選別

自動的に抽出されたシーンタグはシーンと関連性のない有効ではないシーンタグを含んでいる.それらのタグを自動的に選別することは困難なので,実際の応用を開発するために手作業での選別を用いることにした.そこで,Webユーザが自動的に抽出されたタグから自動的に適切なシーンタグを選択することが可能なタグ選別システムを開発した.

映像シーンと同期したシーンタグがユーザに提示される.システムはそれらのタグと関連したシーンを閲覧しているユーザに対して抽出されたシーンタグを自動的に提示する.それぞれのタグはチェックボックスが付与され,ユーザは現在のシーンと関連するものを選択することによってタグ選別することが可能になる.(図)タグを選択する時間がタグを選別するコストである.多くのユーザが参加することによって,一つ当たりのタグを選択するためのコストは小さくなる.これはつまらない仕事であるため,より効率的にタグを選別できる機能を提案する必要がある.

図6: タグスクリーニングシステム

6 実験結果

我々が提案したコミュニケーションを目的としたアノテーションから,検索などの応用に有用な情報がどれくらい取得可能であるかを検証するために,本論文で提案したSynvie(http://video.nagao.nuie.nagoya-u.ac.jp/)の公開実験を行った.2006年7月1日から公開を開始し,2006年10月22日までの期間において収集されたデータに基づき評価を行う.この期間に,登録ユーザ数97人,投稿コンテンツ94個,1コンテンツあたりの平均メディア時間は321.5秒,総閲覧数は7,318回に達した.投稿されたビデオクリップは,教育,旅行,エンターテイメント,乗り物,動物などであり,素人ユーザが作成したものであり,平均320秒の長さがある.

また,YouTubeのような既存の映像共有サービスと実験サービスを比較する.YouTube型コメントはわれわれのコンテンツコメントに対応する.我々は更にシーンコメント型とシーン引用型のアノテーションを提供した.我々のサービスを利用して生成されたこれらのアノテーションの質と量を比較することによって,これらのアノテーションの有効性を確認する.

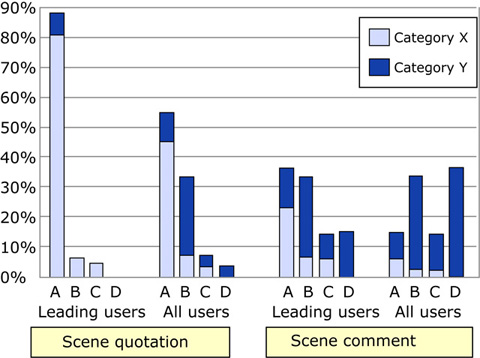

6.1 アノテーションの品質分類

我々の実験によって獲得されたアノテーションデータは主に一般のWebユーザによって作成されたテキストコメントからなる.次のセクションで述べる映像シーン検索システムでそれらを使った.この目的のために,それぞれのメッセージは映像シーンの内容を的確に表現し,よい言葉づかいであるべきだ.それゆえ,それぞれのコメントの特性を評価する必要がある.対応するビデオシーンの内容とコメントの内容の関連性を考慮し,次のA?Dのクラスに蓄積されたアノテーションのすべての手作業で分類した.

-

A. 主にシーンの内容を説明・解説するコメント.

-

B. 主にシーンに対する直接的な感想や意見などからなるコメントで,シーンに関連するキーワードが含まれるもの.

-

C. 主に,シーンの内容から派生した話題に関するコメント.

-

D. 不適切コメント: 感嘆符のみ,形容詞のみなど単独では内容を理解できないもの.あるいは,撮影手法,映像の品質に対する感想など,シーンの内容とは関係のない話題からなるコメント.

さらにA,B,Cのカテゴリに関して,コメントの文章としての正しさに基づき,

-

X. コメントに主語・述語・目的語が存在するなど,十分に内容を表現している.

-

Y. 十分に内容を表現しているとはいえない.

なお,分類は2人の評価者によって同時に行い,異なる意見が出た場合には話し合いによる調整を行った.

A-Xのアノテーションの例としては,朝顔の展示に対して映像撮影者が自身のブログで「名古屋式盆養切込みづくりの朝顔です. 蔓を伸ばさずに盆栽仕立てにしていてとてもユニークです.100年の歴史があるそうです.」と記述したコメントのように,シーンの内容を的確に表現しており言語解析などを行うことによって,より多くの知識の抽出が期待できる.A-Yのアノテーションの例としては,Webアプリケーションのデモ映像で画像のアップロードを行っているシーンに対する「画像のアップロード」というコメントのように,シーンの内容を表現しているキーワードを含んでいるが,十分に内容を表現しきれていないものである.B-Xは「私にとっての朝顔は,こういう蔓を上へ上へと伸ばしていくタイプです.」のようにシーンに対しての感想や意見を述べているものであり,B-Yは「どれだけお菓子使うんだよ!笑」のような表現であり,ともにシーンの内容に関するキーワードの抽出が期待できる.C-Xの例としては映像中に表示されるURLのキャプションに対して「リサイクルトナー専門店のようです. 著作権フリーのCG,音楽を製作されているみたいです.」.C-Yの例としては「長尾先生といえば,アノテーションの研究」などである.これらは,関連する話題について記述しており,必ずしも映像シーンの内容を直接的に表現していないが,シーンに関する補助的な情報としての利用が期待できる.Dの例としては「すごっ!」や「キター」など,単独では意味をなさないコメントや,「なんでこの回だけ映像がぶれてるのでしょう?ウィンドウズメディアエンコーダーという無料ソフトで,ノンインターレス化できるので是非.」など映像の品質に関する話題などが含まれる.

図7: 各手法に対するアノテーションの品質

6.2 品質についての議論

獲得されたアノテーションの多く(795)はシーンコメントであり,その半分(334)がシーン引用,コンテンツコメントは40しかなかった.獲得されたアノテーションの数とアノテーションの使いやすさは関係があると考えている.多くのアノテーションはシーンコメントであったため,シーンコメントはこれらの三つのコミュニケーションツールの中ではもっとも使いやすいといえる.シーンコメントの方が作りにくいのでシーンコメントよりもコンテンツコメントの方が多いと考えられるかもしれないが,しかしながら,同じシーンを見ているユーザは文脈を共有し,それゆえ,短いコメントでも容易に投稿可能である.

図によると,シーンコメントよりもシーン引用の方が良い.すべてのユーザによって投稿されたシーンコメントの11%のみが有効であるのに対して,すべてのユーザによって投稿されたシーン引用のうち59%が有効である.すべてのユーザによって投稿されたシーンコメントの36%が最も低い評価(カテゴリD)であったのに,すべてのユーザによって投稿されたシーン引用のうち4.8%のみがカテゴリDであった.これは,シーン引用にはスパムコメントや不適切なコメントが少なかったことが大きく影響している.

この結果は,文脈を共有する必要がないユーザによって,ブログエントリーのために用いられるシーン引用は,ユーザ間で映像をみて文脈を共有しているユーザ間でのその場でのコミュニケーションに用いられているシーンコメントよりもより丁寧であることを示している.この結果は,ブログで書かれているテキストの品質は一般的に掲示板のテキストよりも高品質であるという事実を反映している.それゆえアノテーションの質はアノテーションの型に依存する.

ここで,カテゴリAに属するアノテーションんを多く投稿した30%のユーザをリーディングユーザとして定義する.図はリーディングユーザによって作成されたシーン引用の95%が有効であり, すべてのユーザによって投稿されたもののうち62%が有効であり,リーディングユーザによって投稿されたシーンコメントでさえ43%が有効である.アノテーションの質はアノテーションを作成したユーザの特性にも依存する.

我々の映像シーン指向のアノテーション方式はより多くの質の高い情報を獲得できることがわかる.そして,アノテーションの質と量は掲示板型のシーンコメントかWeblog型のシーン引用かにも依存する.より多くのアノテーションが獲得できた時はシーン引用の情報のみを使うべきだし,アノテーションが少ない場合はシーンコメントの情報も利用するべきだ.

6.3 シーンタグについての議論

前章で記述したテクニックをもちいて生成されたタグは,我々は手作業で,対応するシーンの内容に密接に関係しているかどうかによって,有効か否かをクラス分けした.半分以上(59%)のタグが有効であると判断した.

シーン引用からは3倍以上もの有効タグが抽出された:一つのシーン引用から獲得された有効タグの平均値は5.96であり,シーンコメントから獲得された有効タグの平均値は1.51である.どちらのアノテーションもシーンについて議論している.しかし,シーン引用はより詳細に記述されており,また有効タグのソースになりやすい傾向がある.

5章1節で記述したタグ選別の技術によるタグの自動生成の有効さを評価すると,すべてのユーザが投稿したシーンコメントから獲得されたタグの内59%が有効であると分かった.これはそんなに高い数値ではないが,すべてのアノテーションは多かれ少なかれその映像を見ながら書いたという点においてシーンに関連している.それらのタグは現在は有効ではないタグとして分類されているが,いくつかの応用によっては有効になるかもしれない.

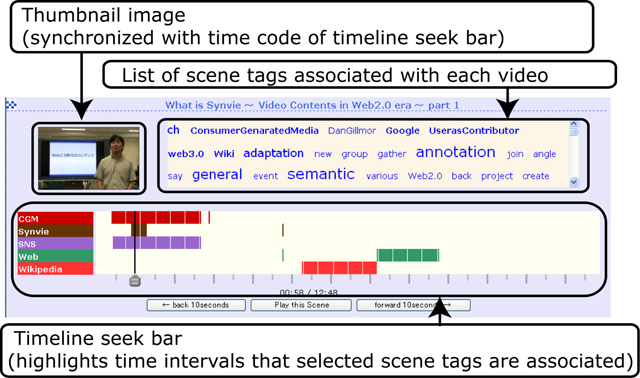

7 アノテーションに基づく応用

Synvieによって獲得されたアノテーションの有効性を確認するために,タグクラウドの仕組みを用いた映像シーン検索システムを開発した..

シーンタグがアノテーションから自動的に生成されたとき,適切なタグがすべてのシーンに付与されているわけではない.そして,すべての映像に対して十分なアノテーションが付与されていなければ,既存の一般的な検索技術は適用できない.

これらの問題に対処するため,映像シーン検索にタグクラウドの仕組みを適用した.ユーザはすべてのビデオに対するすべてのシーンタグから成るタグクラウドの一覧からいくつかのタグを選択する.システムはそれらのタグを含むビデオの一覧を表示する.それぞれのビデオはシーンタグと関連づいたシークバーを持っており,時間軸にそってサムネイル画像が表示される(図).ユーザがシークバーをドラッグすると,システムはシークバーと同期したサムネイル画像とシーンタグを提示する.それらのタグとサムネイル画像を閲覧することによって,映像を実際に見ることなく映像の内容を確認することができる.さらに,ユーザが興味を持ったタグをクリックすると,シークバーの上にタグの時間分布が表示される.ユーザはシーンタグやタグの時間分布やサムネイル画像を用いて対象を検索することができるので,シーンを対話的に探索できる.

図8: シークバーとタグに基づくビデオ検索のインタフェース

7.1 シーン検索の評価

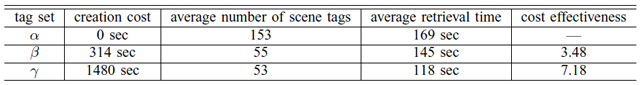

我々はα,β,γの三つのデータセットを実験のために用意した.αは5章1節で自動生成されたタグから抽出されたシーンタグのデータ集合である.βは5章2節の手法を用いて手作業でタグ選別した結果抽出されたシーンタグのデータ集合である.γは比較実験のためにシーンタグを手作業で作成するツールを用いて生成したシーンタグの集合である.作成コスト(1コンテンツあたりの総作成時間)は,αは0秒,βは314秒,γは1480秒であり,表に示す.シーンタグの平均数はαで152,βで55,γで53個である.これらの値は作成やタグ選別のインタフェースに依存しやすいが,それぞれなるべく同じタイプのインタフェースを利用した.

対象となるコンテンツはSynvieに投稿された27個のビデオである.それぞれのビデオの平均長さは349秒である.検索問題は,ぼかしたサムネイル画像と回答シーンの内容を記述した文章から成る.回答シーンに特徴的なキーワードが含まれる問題文があると簡単に見つけられてしまうので,それらのキーワードを含めないように留意した.ユーザがぼんやりと覚えている対象シーンを探すシチュエーションを想定している.

問題文の例は,「ある動物の親子が道の真ん中で佇んでいるシーン」や「ある人がスノーボードをしていて,コースアウトする前のシーン」なのである.被験者(大学生9人)はわれわれのシステムを用いて各問題に対応したシーンを検索する.そして,検索時間を計測する.α,β,γのそれぞれに対して9つのシーンを検索する.

図9: ビデオシーン検索の実験結果

7.2 議論

本実験によって,すべてのユーザは正しいシーンを見つけることができた.表 に示すように,αの平均検索時間は169秒であり,βは145秒,γは119秒であった.αとβに対する検索時間の差はタグ選別技術で削減できた時間である.

自動タグ生成の費用対効果を評価するために,βとγにおける検索時間と作成時間の比較を行う.βの平均作成時間は314秒であり,γの平均作成時間は1480秒である.作成時間100秒あたりにどれだけの検索時間が削減できるかで費用対効果を定義する.γが3.48であるのに対して,βは7.18だ.つまり,タグ選別手法は費用対効果の点において有意である.

これらの実験によって,Synvieによって獲得されたアノテーションから抽出したタグは映像シーン検索に有用であることを示した.しかしながら,実験結果はアノテーションの量に依存するので,詳細な評価は今後の課題だ.タグ選別技術は検索効率向上に有意義であり,対象映像コンテンツや検索頻度のようなファクターを適切に考慮してタグを利用するべきだ.

8 結論

Synvieの主な目的は,ビデオ共有とユーザコミュニケーションと内容アノテーションの新しい統合アプローチを提案することだ.ビデオの深い内容とビデオに関するユーザコミュニケーションを関連付けることによって,映像シーンの知識を発見することが可能になり,応用にそれを利用可能になる.これらのコミュニケーション空間は一つのビデオ共有サービスの中で閉じているべきではないので,我々のシーン引用はそれをWeb全体へと拡張することができる.またユーザは普通タグの作成や選別は億劫である.それゆえ,これらの映像シーンの協調タギングの良いモチベーションになると信じている.我々の目的を達成するために,ビデオシーンに対するアノテーションと,ビデオシーン引用を含むブログエントリーからアノテーションを獲得する仕組みを開発し,公開実験によって評価した.それぞれのアノテーション手法に対するアノテーションの解析から,それぞれのアノテーション手法の特性を発見した.我々はまた,これらのアノテーションに基づく,タグに基づくビデオシーン検索システムを開発した.これらのWebコミュニティから獲得したアノテーションはビデオシーン検索などの応用に有効であることを示した.

しかしながら,本論文では解決されていないいくつかの問題がある.現在,我々はタグしか抽出していない.我々はシーンタグにオントロジーの概念を適用することによって,あるいは,より高度な言語解析技術を利用することによって,より多くの意味的な情報を獲得する必要がある.これらのメカニズムを用いることによって,我々はビデオシーンの引用に基づく意味的なハイパーメディアネットワークを構築することが可能になる.ブログエントリーとビデオコンテンツから成るこれらのネットワークにおいて,ハイパーリンクの粒度はビデオやブログエントリーの単位からシーンや段落の単位へ,ネットワークの大きさは一つのサイトから成るコミュニティからイン尿の意味に基づく意味的なものに拡張することができる.我々はそれゆえ,コミュニティの活動からマルチメディアコンテンツに関する知識を獲得するこの一般的な手法は多くの応用に適用可能であると考える.